翻译技术教育与研究 2024年12月21日 09:01 陕西

以下文章来源于AI信息Gap ,作者木易的AI频道

AI信息差,让一部分人先AI起来。

小编速览

OpenAI直播发布第九天,正式推出满血版o1模型API、全面升级的实时API,以及偏好微调(Preference Fine-Tuning) 技术。此外,实时API的价格大幅降低。

大家好,我是木易,一个持续关注AI领域的互联网技术产品经理,国内Top2本科,美国Top10 CS研究生,MBA。我坚信AI是普通人变强的“外挂”,所以创建了“AI信息Gap”这个公众号,专注于分享AI全维度知识,包括但不限于AI科普,AI工具测评,AI效率提升,AI行业洞察。关注我,AI之路不迷路,2024我们一起变强。

今天是OpenAI连续12天直播发布会的第9天。关于OpenAI本次的宣传“噱头”详情,可以看我这篇文章:活动预告:明天起OpenAI将开启连续12天的直播发布!

本系列将在每个工作日持续更新,为小伙伴们带来第一手的更新解读,敬请关注。

一图看懂今天的发布

接下来正文开始。

Day 9 发布内容

今天OpenAI的发布是一个DevDay,顾名思义,是面向开发者的发布。

一般来说,面向开发者的发布内容逃不过三个“更”:更好的模型API,更低的调用价格,更新的技术。今天也不例外,这三点都有。

更好的模型API包括2个:正式推出满血版o1模型API,和全面升级的实时API。

更低的调用价格:实时API的价格大幅降低,比如gpt-4o-realtime-preview-2024-12-17音频token价格降低60%。

更新的技术:正式推出偏好微调(Preference Fine-Tuning) 技术,基于直接偏好优化(DPO)算法,通过比较模型生成的不同响应,学习人类偏好,而非依赖于精确的输入-输出对,达到根据用户和开发者偏好优化模型表现的效果。

o1模型正式在API中推出

满血版本的推理模型o1最初发布于OpenAI直播发布活动的首日,即12月5日。但当时发布的是o1的应用版本,即集成进ChatGPT,可以给C端用户直接使用的版本。

今天发布的则是满血版o1模型的API版本。API版本主要面向开发者或者有一定动手能力的小伙伴。

o1模型API核心功能

-

函数调用(Function Calling):

函数调用功能允许o1模型与外部API和数据源进行交互,自动选择正确函数并执行任务。比如在今天demo中的税表演示中,o1能够调用外部税率查询函数,这展示了o1模型与现实世界系统集成的能力。

-

结构化输出(Structured Outputs):

支持输出符合自定义JSON Schema的结果,保证结果格式一致,便于开发者集成。

-

开发者消息(Developer Messages):

新型系统消息,开发者可精确控制o1模型的行为,例如指定语气、风格或上下文顺序。有点类似于系统提示词。

-

推理参数控制( reasoning_effort):

这是o1这样的推理模型独有的参数,用来控制o1模型的推理时间,在简单任务中节省成本,在复杂任务中提升效果。

-

视觉输入(Vision):

o1模型支持图片输入,用于错误检测、科学分析等多种场景。

-

延迟大幅降低:

o1比预览版减少60%推理token数消耗,从而使响应速度更快、成本更低。

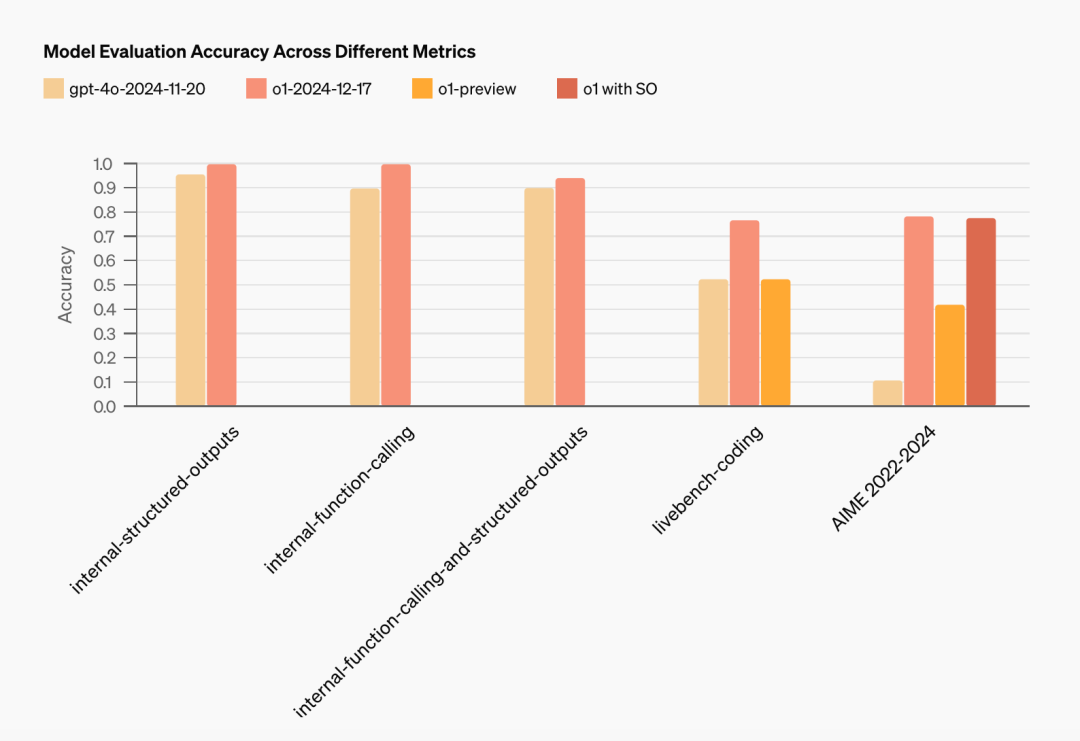

o1模型API基准测试表现

当前的满血版o1模型调用名为o1-2024-12-17。下面是满血版o1API和之前的预览版本API的基准测试性能表现对比。

| Category | Eval | o1-2024-12-17 | o1-preview |

|---|---|---|---|

| General | GPQA diamond | 75.7 | 73.3 |

| MMLU (pass @1) | 91.8 | 90.8 | |

| Coding | SWE-bench Verified | 48.9 | 41.3 |

| LiveCodeBench | 76.6 | 52.3 | |

| Math | MATH (pass @1) | 96.4 | 85.5 |

| AIME 2024 (pass @1) | 79.2 | 42.0 | |

| MGSM (pass @1) | 89.3 | 90.8 | |

| Vision | MMMU (pass @1) | 77.3 | — |

| MathVista (pass @1) | 71.0 | — | |

| Factuality | SimpleQA | 42.6 | 42.4 |

| Agents | TAU-bench (retail) | 73.5 | — |

| TAU-bench (airline) | 54.2 | — |

同时,在demo里OpenAI的研究人员展示了o1-2024-12-17在函数调用和结构化输出方面要明显优于上一个版本o1-preview。

o1模型API谁能用?

o1-2024-12-17将会优先向账号使用级别为第5层(usage tier 5)的开发者访问,符合条件的用户将收到OpenAI的邮件通知。OpenAI官方表示,预计需要几周时间才能覆盖所有Tier 5用户。言外之意:还得等。

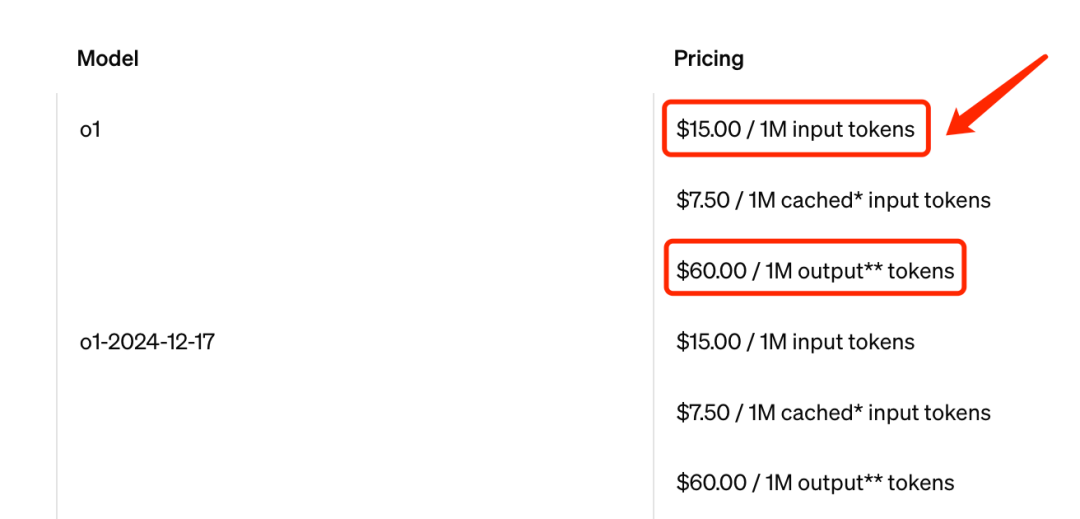

o1模型API价格

满血版o1的API价格和预览版本相同,输入token的价格为15美元每百万tokens,输出token的价格为60美元每百万tokens。算是比较贵,但考虑到其优秀的推理能力,如果真有这方面的需求,o1API也算是贵在点上了。

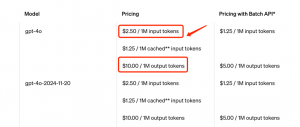

作为对比,附上GPT-4o模型API的价格,输入token的价格为2.5美元每百万tokens,输出token的价格为10美元每百万tokens。输入和输出token价格均为o1的六分之一。

实时API全面升级

实时API(Realtime API) 让开发者能够创建低延迟、自然流畅的交互体验,非常适用于语音助手、实时翻译工具、虚拟导师、语音客服,甚至是自定义的虚拟助手(比如“虚拟圣诞老人”)。可以简单理解为ChatGPT里高级语音模式的API版本,可以通过实时API自行创建高级语音模式。

WebRTC集成

对于实时API,今天最为重磅的发布无疑是引入了WebRTC的支持。WebRTC是一种开放标准,无论是基于浏览器的应用、移动端App、物联网设备,还是服务器到服务器的直接通信,WebRTC都能够简化跨平台实时语音产品的构建与扩展。

WebRTC集成旨在确保在真实世界网络条件下提供流畅且响应迅速的交互体验,即使网络质量不稳定也能轻松应对。它处理的核心功能包括:音频编码与流传输、噪音抑制以及网络拥塞控制。

通过WebRTC集成,开发者只需12行JavaScript代码就可以轻松添加实时语音功能,这也是今天的demo中展示的代码。

async function createRealtimeSession(localStream, remoteAudioEl, token) { const pc = new RTCPeerConnection(); pc.ontrack = e => remoteAudioEl.srcObject = e.streams[0]; pc.addTrack(localStream.getTracks()[0]); const offer = await pc.createOffer(); await pc.setLocalDescription(offer); const headers = { Authorization: `Bearer ${token}`, 'Content-Type': 'application/sdp' }; const opts = { method: 'POST', body: offer.sdp, headers }; const resp = await fetch('https://api.openai.com/v1/realtime', opts); await pc.setRemoteDescription({ type: 'answer', sdp: await resp.text() }); return pc;}

实时API价格

目前实时API提供GPT-4o和GPT-4o mini2个版本。其中,GPT-4o实时API的最新版本名为gpt-4o-realtime-preview-2024-12-17,价格得到了大幅降低,每百万输入和输出tokens价格分别是40和80美元,而在这之前,实时API的价格为100和200美元,本次更新音频token价格降低了60%。

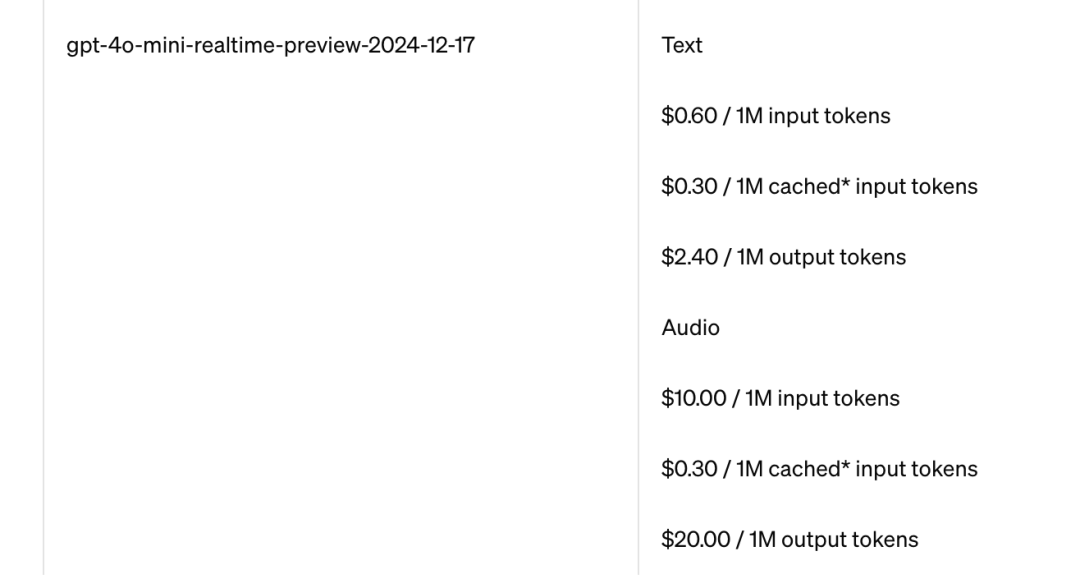

同时,今天也发布了实时API的小模型gpt-4o-mini-realtime-preview-2024-12-17,目前是Beta版本,主打质量和成本的平衡。GPT-4o mini实时API价格为10美元和20美元,分别对应每百万的输入和输出token。

实时API功能增强

-

并行后台响应(Concurrent out-of-band responses): 支持后台任务(如内容审核或分类)与语音交互并行执行。 -

自定义输入上下文 (Custom input context): 开发者可以灵活选择模型输入内容,例如仅对用户的最后一次发言进行审核,或重用之前的响应。 -

响应时机控制(Controlled response timing): 结合服务器端语音活动检测 (VAD),实现更精准的语音回复控制,例如在收集必要信息(如账户详情)后触发语音回复。 -

最大会话时长(Increased maximum session length): 从15分钟延长至30分钟。

偏好微调(Preference Fine-Tuning)

微调API现已支持偏好微调(Preference Fine-Tuning),使开发者能够根据用户和开发者的偏好轻松定制模型。该方法使用直接偏好优化(Direct Preference Optimization,DPO),通过比较一对模型响应,教会模型区分优选与非优选的输出。与基于固定目标学习不同,偏好微调通过成对比较的方式进行训练,特别适用于注重语调、风格和创造力等主观性任务。

偏好微调与传统的监督微调的区别可以总结为下表。

| 监督微调 (SFT) | 偏好微调 (PFT) | |

|---|---|---|

| 目标 | 通过复制标注的输出,鼓励模型生成正确结果 | 优化模型行为,强化优选响应,减少非优选响应的可能性 |

| 训练数据 | 精确配对的输入和输出 | 优选和非优选模型输出的成对数据,通过人工标注、A/B 测试或合成数据生成 |

| 适用场景 | 适用于易于准备理想输出的任务,如定制代码格式,且需要严格的正确性 | 适用于“更好”响应带有主观性的任务,如创意写作或摘要任务 |

OpenAI表示已经与一些受信任的合作伙伴测试了偏好微调这一技术。例如,Rogo AI正在开发一款面向金融分析师的AI助手,该助手将复杂的查询拆分为子查询。在他们自行构建的Rogo-Golden基准测试中,监督微调在解决分布外查询扩展时遇到了困难(例如,在处理“公司X增长速度如何”这样的查询时,缺失ARR等指标),而偏好微调解决了这些问题,将基准测试的准确率从基础模型的75%提升至80%以上。

偏好微调支持哪些模型?

偏好微调今天起将优先支持gpt-4o-2024-08-06模型,很快也将支持gpt-4o-mini-2024-07-18。训练token的价格与监督微调相同,支持更多新模型的更新计划将在明年初推出。

偏好微调怎么用?

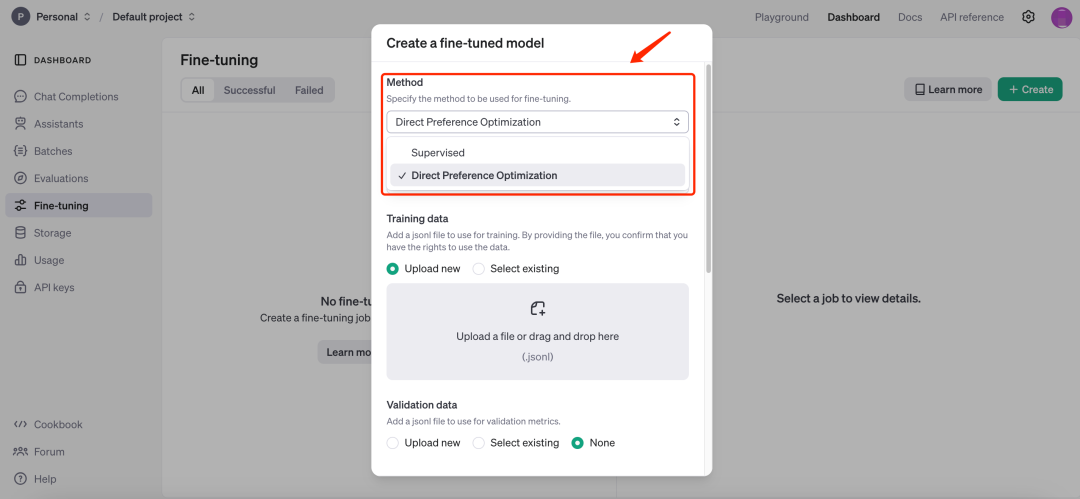

偏好微调今天起已开放使用,在OpenAI的开发者后台-Dashboard–Fine-tuning,新建微调模型,Method选择“Direct Preference Optimization”即可。

https://platform.openai.com/finetune

OpenAI 12天直播发布回顾

OpenAI于12月5日开启“12天发布季”,本系列将在每个工作日持续更新,为小伙伴们带来第一手的更新解读,敬请关注。

| 日期 | 发布关键词 | 详细解读文章 |

|---|---|---|

| ? Day 1 | 满血版 o1 · ChatGPT Pro 新套餐 |

? 满血版o1,200美元/月的ChatGPT Pro新套餐! |

| ✨ Day 2 | 强化学习微调 (RFT) |

? o1+强化学习微调=定制化推理模型! |

| ? Day 3 | 文生视频模型 Sora |

? Sora文生视频模型真的来了?! |

| ?️ Day 4 | ChatGPT Canvas |

? ChatGPT Canvas全面升级,免费开放! |

| ? Day 5 | Apple Intelligence |

? ChatGPT+Siri=新Apple Intelligence! |

| ? Day 6 | 视频聊天 · 屏幕共享 · 圣诞模式 |

? ChatGPT视频聊天、屏幕共享和圣诞语音包! |

| ? Day 7 | ChatGPT Projects |

? ChatGPT推出Projects,本周最强功能! |

| ? Day 8 | ChatGPT Search |

? ChatGPT Search全面升级,免费开放! |

结语

今天是OpenAI开发者日节日限定款,更好的模型API,更低的调用价格,更新的技术。