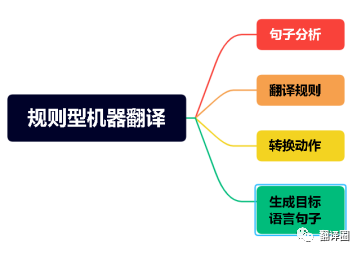

是机器翻译的早期方法之一,它基于人工编写的语法和规则来实现翻译。

翻译过程包括以下几个步骤:

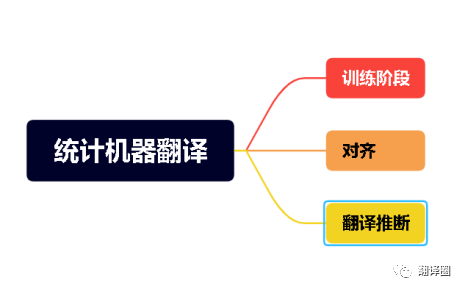

是一种基于统计模型的机器翻译方法,它利用大规模的双语平行语料来学习源语言与目标语言之间的翻译概率和模式。

翻译过程包括以下几个步骤:

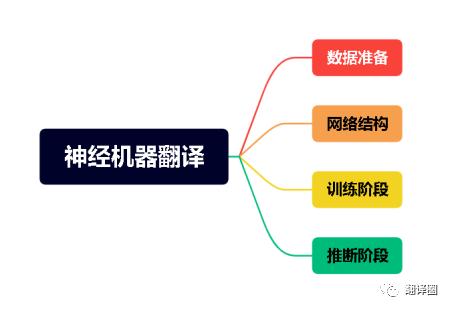

是一种基于神经网络的机器翻译方法,它采用端到端的学习方式,将源语言句子直接映射到目标语言句子。相比于传统方法,NMT在流畅性和翻译质量上取得了显著提升,并且能够更好地处理长距离依赖。

翻译过程主要包括以下几个步骤:

然而,神经机器翻译也存在一些挑战:

1. Hutchins, W. J., & Somers, H. L. (1992). An introduction to machine translation. Academic Press.

2. Koehn, P. (2010). Statistical machine translation. Cambridge University Press.

3. Sutskever, I., Vinyals, O., & Le, Q. V. (2014). Sequence to sequence learning with neural networks. In Advances in neural information processing systems (pp. 3104-3112).

4. Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., … & Polosukhin, I. (2017). Attention is all you need. In Advances in neural information processing systems (pp. 5998-6008).