译学文献 | 智能技术赋能语言测试的伦理思考

2024年08月30日 00:00 陕西

智能技术赋能语言测试的伦理思考

金艳 徐孟婕

作者简介:

金艳,教授,博士,研究方向:语言测试;邮箱:yjin@sjtu.edu.cn

徐孟婕,博士生,研究方向:语言测试。

摘要:

大语言模型和生成式人工智能技术的崛起对外语教育产生了深远影响,为教学和测试带来了机遇,同时也出现了伦理方面的挑战。本文聚焦语言测试中的智能技术应用,旨在提高语言测试领域对相关伦理问题的重视。首先,本文回顾了智能技术赋能背景下的语言测试实践,并提出了智能测评技术应用中的伦理风险分析框架。其次,基于该分析框架,本文从意识形态和价值观导向、测试公平和公正性、测试透明度和分数解释力、数据和信息安全以及社会和教育层面的影响等方面,剖析了智能测评技术应用中的伦理问题。最后,本文探讨了以人为本的人工智能伦理观在语言测试中的应用,提出了负责任地应用智能技术的操作性建议,并倡导人机协同的智能测评模式。

1. 引言

人工智能(artificial intelligence, 简称AI)这一概念于1956年被首次提出(Russell & Norvig 2020)。中国科学院院士谭铁牛对人工智能领域的定义是“研究开发能够模拟、延伸和扩展人类智能的理论、方法、技术及应用系统的一门新的技术科学”(谭铁牛2019: 40)。AI的发展经历了计算智能、感知智能和认知智能三个阶段。第一阶段,计算机拥有了强大的记忆力和超快的计算能力;第二阶段,计算机模拟人的视觉、听觉等功能,实现了语音识别和图像识别;进入第三阶段后,计算机开始模拟人的思维,对知识进行组织、整理、灵活运用、联想推理等(吴睿2022)。Open AI于2022年末发布的Chat GPT具有强大的人机互动能力,标志着信息社会进入了划时代的人机交互阶段,对外语教育产生了深刻影响(Crompton & Burke 2023; Lee et al. 2024)。大语言模型(large language models, LLMs)和生成式人工智能(generative AI, Gen AI)的问世,在一定程度上向实现AI研究的终极目标迈近了一大步,即AI能够“像人类一样思考,且理性地思考;像人类一样行动,且理性地行动”(UNESCO 2019:8)。

在智能化的时代背景下,语言测试领域正朝着自动化测评方向迈出重要的步伐。人机对话、远程监控、自动评分、诊断反馈等技术日趋成熟,自动编写语料、命题和参数估计等也正在成为现实(Xi 2023)。智能技术的推广和应用给语言测试带来了机遇,但同时也出现了伦理挑战。本文结合前沿文献和案例分析,探索智能技术在语言测试特别是大规模考试中的应用,及其产生的伦理问题,倡导以人为本的AI伦理观和人机协同的智能测评技术应用模式。

2. 智能技术在语言测试中的应用

2.1智能测评技术应用案例

语言测试,尤其是大规模考试的发展,与技术应用密不可分。心理与教育测量技术在分数等值、效度论证、认知诊断等方面发挥着重要作用,信息和计算机技术的发展促成了计算机化考试,智能技术已被广泛应用于大规模语言考试的自动评分和远程监考等环节。

深度学习和自然语言处理等技术在口语或写作测试的自动评分中得到了应用,如美国教育考试服务中心(Educational Testing Service, ETS)的e-rater写作自动评分引擎、英国培生Versant口语自动评分系统、大学英语四、六级口语、写作和翻译测试的自动评分系统(Knoch et al. 2021; Xi 2010, 2023; 张晓艺等2024)。经过学习和训练,自动评分系统还可以批改作文并提供反馈信息,如Criterion在线写作评估、Write To Learn系统;国内的批改网、i Write等英语写作教学与评阅系统等。

2020年以来,为方便考生参加考试,技术公司开发了AI辅助的远程监考系统,使居家考试成为现实,且已在托福、雅思、多邻国英语测试等高风险考试中使用(Isbell et al. 2023)。为确保居家考试的安全性,技术公司尝试了多种远程监考优化方案,包括网络摄像技术、复杂的软件或仿生学安全系统,以防止考试作弊等不当行为。目前,进入实际应用领域的主要是以下三种远程监考模式:人工远程实时监控,这种模式费时费力,但最为可靠;全程录像监控,这种方式省时省力,但考后的录像审核工作量大;系统自动监控,这是AI应用程度最高的全自动远程监考模式,省时省力,但系统可能出现偏差。Isbell等(2023)认为,一定程度的人工参与应该成为高风险远程考试的必要条件。

国际语言测试协会(International Language Testing Association, ILTA)于2023年5月举办网络研讨会,以“Chat GPT应用及其对语言测试的影响”为主题,探讨了智能技术背景下的语言测试开发和实施。随着LLMs和AI视频生成工具的推广和应用,语言测试领域正在探索模拟对话、多模态交际或虚拟交际语境中的语言能力测评,以拓展语言测试的构念,并丰富测试的方法和手段。

2.2伦理风险分析框架

技术创新“对测试任务设计、考试实施、评分、效度研究等产生了重要影响”(Van Moere & Downey 2016: 342)。金艳等(2021)基于大学英语四、六级考试的实践,从效度、效率以及安全和公平性等方面综合考虑,提出了一个大规模考试技术应用评价体系。在效度方面,评价体系重点关注技术应用是否有助于全面、准确地测量相关构念,避免构念代表性不足和构念无关,同时关注考试产生的反拨效应和社会影响。从效率来看,技术应用旨在推进考试自动化进程,使考试更高效。因此,评价体系从考试设计、实施和评分等环节,评价技术应用能否在确保考试质量的前提下提升考试效率。在考试管理和实施方面,评价体系关注技术应用是否有助于加强考试信息的有效管理、题库的安全保密、考生异常作答检测、高科技作弊的预防、考生身份甄别、考试过程监控等,以确保考试安全和公平。

尽管该评价体系具备较强的全面性和系统性,但对智能测评技术带来的伦理问题缺乏足够重视。研究表明,以Chat GPT为代表的LLMs应用,存在许多伦理问题。不负责任的技术应用可能导致偏见或歧视,而且,学术领域的智能技术应用,一定程度上加重了人们对技术的依赖和思维惰性,诸如审辨思维、主观能动性、创造力等人类独有的特质可能被相应削弱(胡开宝、王晓莉2022)。因此,对智能技术的学术伦理考量和理性规约就显得尤为迫切(令小雄等2023)。

Hao等(2024)认为LLMs和Gen AI技术用于文本处理时,在以下七个方面表现出局限性:(1)可解释性。LLMs背后庞大的数据和算法是一个无法打开的“黑箱”,用户只能看到结果,却无法理解结果是如何产生的;(2)训练数据。用户无从得知训练数据是否受版权保护,若输出内容与训练数据过于相似,有被标记为抄袭的风险。而且,训练数据可能自带偏差,从而产出带有歧视的结果;(3)信息真实度。AI会产生幻觉,即“一本正经地胡说八道”,生成与事实不符的结果;(4)可外推性。LLMs依赖的是结构化数据,难以理解人类的言下或言外之意,无法达到人类的理解深度;(5)结果一致性。LLMs基于概率且实时更新,因此,即便提示信息完全相同,也无法确保结果完全一致;(6)数据安全与隐私。当用户的提示语和生成的文本被用于建模时,会对数据安全、知识产权、隐私等方面构成威胁。托管服务可以提供更多隐私保护,但开发成本较高;(7)安全性。AI不仅会产出虚假信息,甚至可能生成有害或危险的内容,即便通过强化学习,仍无法确保系统输出安全、可靠、合法的信息。

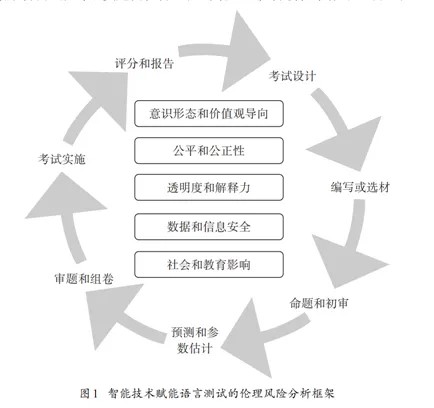

这些技术缺陷是导致某些伦理问题的内因。例如,AI系统用于招聘员工时,可能会基于求职者的性别、种族或族裔等产生歧视。路透社曾报道,美国亚马逊公司的智能招聘引擎对应聘者存在歧视(Dastin 2018)。近期,有学者联名抵制将AI写作检测软件用于评估学生作业,因为这些软件可能会无意中“惩罚”母语为非英语的学生群体(Liang et al. 2023: 1)。而且,如果AI技术应用或管理不当,如使用场景不合理、监管政策不当、伦理规范不完善等外因,同样会给语言测试实践带来伦理风险。为了厘清智能测评技术本身或其应用过程中可能产生的伦理问题,我们根据语言测试设计和实施流程,提出一个伦理风险分析框架,如图1所示。

图1中的外圈表示AI技术正逐步被应用于语言测试的各个环节,包括考试设计、编写或选材、命题和初审、预测和参数估计、审题和组卷、考试实施以及评分和报告。圈内的列表呈现了语言测试开发和实施过程中需要特别关注的伦理问题。例如,在“编写或选材”或“命题和审题”环节,AI输出的结果可能会存在意识形态和价值观导向问题;在“考试实施”环节,智能技术应用于远程监考可能带来测试公平、公正性问题;在“评分和报告”环节,AI技术缺陷带来信息透明度问题,自动评分产生分数解释力问题;此外,在考试开发和实施过程中,智能技术的应用和监管给数据和信息安全带来风险,也可能对社会或教育体系产生多方面影响。下面我们将从这几个方面详述智能技术赋能语言测试的伦理风险。

3. 智能技术赋能语言测试的伦理风险

3.1意识形态和价值观导向

教育测量是一种具有价值导向的行为,测试工作者需要在实践中以合乎价值观和道德准则的方式作出决策。在外语测评中,当AI技术被用于挑选或编写测试材料时,价值观导向问题尤为突出。例如,为了提高命题效率和素材的真实性,英语考试通常会选用来自英美国家的原版材料,并利用AI进行改编,或者直接让系统根据提示编写素材。AI系统根据设定的模式和目标分析数据并作出决策,但这些决策不基于个人的意识形态、价值观或信念,即系统无法评估意识形态或判断其价值。如果命题人员对这些素材所传递的意识形态和价值观缺乏判断力,可能会出现不良导向。而且,AI的“幻觉”可能导致系统提供虚假信息或虚构知识,甚至产生有害信息。

当前,思政教育在国内受到高度重视,已经全面融入外语课堂教学和评估中。确保正确的意识形态和价值观导向是思政教育的首要任务。孔蕾(2024:12-13)在探讨智能技术应用对外语专业教学的影响时指出,智能技术仅能提供“一般化解决方案”,无法提供“与个人经验密切相关的情感和伦理价值”。因此,她建议外语教师应“重视培养学生的情感和价值观,提升学生的道德判断力和社会责任感”。葛颂和王宁(2024: 97)在探讨AI时代的文学翻译时指出,AI系统“缺乏理解人类语言和情感的能力,基本无法在涉及文化内涵和社会冲突的情况下作出选择,从而可能保留和延续现有的偏见和训练数据的偏见”。因此他们强调,“人工译者的作用仍然存在,并且应当得到维护,这应该是起码的翻译伦理原则,尤其是在翻译优秀的文学艺术作品方面,人工译者的作用更是不可取代”。

3.2测试公平、公正性

公平性、多样性和包容性是语言测试领域备受关注的议题(如Kunnan 2000, 2018; Mc Namara et al. 2019)。智能技术的应用给语言测试带来新的公平、公正问题。Garcia和Lee (2020: 254)指出,“技术本身并不是中立的,因为每行代码、每件数字化产品、每种算法、每项产品功能都由人工编写;每种技术都体现隐含的、无形的价值观”。例如,自动评分和反馈系统受到训练集内在偏差的影响,例如样本代表性不足,可能导致对某些群体不公平的评判结果。因此,语言测试领域在应用智能技术时,应避免提供有偏差的数据用于机器学习,并且需要对系统性偏差进行评估、监控和调整。

在测试多样性和包容性方面,智能技术可能对缺乏数字素养或设备的考生产生不利影响。例如,居家考试中的远程监考需要一定的设备、场地和技术应用能力,可能会对资源匮乏的考生或残障考生造成不公平。为满足有需求的个体和群体,智能技术研究人员要细致分析技术应用可能对语言测试产生的影响,清晰界定考生参加测试需具备的智能技术知识和应用能力,并为考生提供必要的培训和技术支持。

3.3透明度和解释力

LLMs背后庞大的模型和算法堪称“黑箱”,研究者们通常只能看到它的运行结果,却无法清楚了解它的运行过程(郑戈2017)。对于自动命题来说,透明度或解释力也许不是必要条件,但是,在自动评分环节,评分系统的透明度和分数的解释力对于考生和考试结果使用者至关重要,而AI技术使自动评分系统成为打不开的黑箱,无法为考试分数提供明确、有意义的解释(Xi 2023)。

目前,语言测试领域应对“黑箱”问题的主要策略是开展人机合作,发掘区别性的显著特征,使AI系统输出的结果可解释。例如,美国ETS致力于开发基于特征的自动评分系统,找出与学生写作能力最相关的典型特征,用于评分和反馈。这些特征不仅能预测分数,还与人工评分时考虑的特征有逻辑对应关系。这些评分特征被纳入统计模型中,每个特征的权重由系统或人类专家决定,目标是使机评分数与人工评分最大程度地相关。在运用基于神经网络的深度学习技术时,我们可以通过“集成学习、知识图谱和注意力机制”或“引入专家经验采用知识引导”等方法提升系统的可解释性,实现“可解释、可归因、可验证的智能化的个性化教育评价”(周东波等2024: 3)。

3.4数据和信息安全性

数据和信息安全性是高风险考试开发和实施的基本保障。随着自动命题、预测和评分等技术的推广和应用,其可能带来的问题是试题或答题数据被AI系统用于模型训练,导致试题泄露,考生信息、答题数据和考试成绩等也无法得到安全保障。商业化运行的大规模考试若采用自动命题系统,还可能会引发版权或著作权问题。例如,AI训练库资料是否有版权?AI能否成为一个有著作权的作者?能否通过著作权来保护AI产出的内容?这些都是涉及到法律伦理层面的问题,目前学界尚未达成共识(於兴中等2023)。

语言测试领域亟需制定相应的政策或法规,来保护考试数据和信息安全。现阶段,语言测试开发者应全面评估AI系统,在确保题库数据安全且不存在版权问题的情况下,采用智能技术支持的自动命题模式;在严密监控考生信息、答题数据、评分数据等安全性的前提下,采用自动评分系统。此外,人机协同的考试开发和实施也是保障考试数据和信息安全的措施之一(详见本文第4.3节)。

3.5社会和教育影响

智能技术对教育理念和方法正在产生广泛影响。英国文化教育协会出版的《英语的未来:全球视野》报告中指出,近年来,教育数字化得以迅猛发展,为学生提供了更多学习英语的机会,但也有可能会加剧“技术鸿沟”,即在不同群体或地区之间,由于技术水平、资源分配等方面的差异而产生不平等现象(Patel et al. 2023)。科技可以彻底改变教育,但是仍有许多教师无法接触到数字技术。研究发现,如何开展AI辅助外语教学是大学外语教师急需解决的问题,其中数字化测评是最薄弱的环节(胡杰辉、张铁夫2023)。从学生来看,个别农村偏远地区甚至没有互联网,更没有机会学习数字技术。弥合技术鸿沟需要对基础设施和培训进行大规模投入,确保不会对某些群体造成不公平的影响。

同样,智能测评技术对社会也产生了多方面影响。例如,自动评分系统的偏差可能会影响测试效度,从而影响升学、就业和人才选拔,甚至加剧社会不公平现象。因此,测试开发者需持续、定期监测和评估AI支持下的语言测试系统性能,及时发现和解决新出现的问题或偏差。而且,测试开发人员、教育工作者、政策制定者等考试利益相关者之间应紧密合作,共同应对智能技术应用可能产生的社会或教育问题。

4. 语言测试中以人为本的AI伦理观

4.1以人为本的AI伦理观

人类与AI的关系复杂而深刻。在康德“人是目的,不是手段”的哲学命题下,具有理性、独立意识和自由意志的人类成为主体,AI技术不管多先进,也只能作为客体、手段存在,人与AI之间必须秉持“以人为本”的价值准则(李高协、齐润发2023)。建筑思想家Cedric Price对人和技术的关系作了深刻的思考。他设想与戏剧导演合作开发一个“游乐宫”(Fun Palace)。这是一个能与用户交互的建筑,在技术的支持下,不断适应用户变化的需求;这也是一个不确定且灵活的建筑,不是为简单地满足人类的需求而建,而是为了鼓励人类与建筑共同创造需求,人和建筑之间存在着一种对话关系。尽管游乐宫并没有建成,但是这个项目的意义重大:“游乐宫并不关乎技术,而是关乎人(Mathews 2006: 47)”。这一观点凸显了人的主体地位,启发人们思考人类、建筑和技术之间的关系。

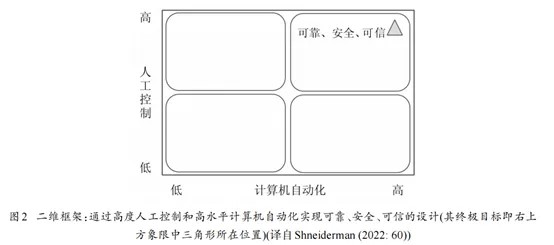

人工智能领域学者Shneiderman (2022)倡导以人为本的AI理念(human-centered AI, 简称HCAI)。为了更形象地解释HCAI的理念,Shneiderman (2022: 59-60)提出了一个二维框架(见图2)。纵轴自下向上代表人工控制的程度由低到高,横轴从左到右代表计算机自动化的水平由低到高,HCAI追求的终极目标是通过高度的人工控制和高水平的计算机自动化,实现可靠、安全、可信的设计,即右上方象限中三角形所在位置。

HCAI的宗旨是研发基于人类价值观的人工智能系统,增强和弥补人的能力,而不是取代人类。该研究领域的主要目标是保护人类价值观,确保AI能够公开、透明地为人类服务,保障公平,并尊重隐私。因此,我们既要充分利用AI技术,帮助解决复杂问题,提高效率,推动社会发展;同时,鉴于AI技术的局限性,例如系统性偏见、对隐私和安全的潜在威胁,以及道德层面的问题等,在发展和应用AI技术时,我们需秉持“以人为本”的理念,规避或减少AI技术可能给人类社会带来的各种危害。

4.2语言测试中的AI伦理观

教育技术领域著名学者Donald Ely (1995)指出,要使技术人性化地为所有人服务,答案并不在于技术本身,而在于人,是人决定了教育技术的使用目的、使用方式以及如何评价技术使用后果。同样,在语言测试领域,我们必须恰当、负责任地使用技术,从任务设计、实施、评分等方面全面提升语言测试的丰富性和可行性(Van Moere & Downey 2016)。

近期,国际教育测量领域有多个关于AI的标准和指导性文件问世。2022年,国际考试委员会和考试出版商协会发布了《基于技术的评估指南》,全面讨论了测评技术应用中存在的问题;2023年,美国教育部发布了《人工智能和教学的未来:见解和建议》,推荐教师为核心的教学理念,鼓励教师参与AI技术设计的决策、技术选择和技术评估;2023年,英国语言测评协会发布《语言测评中的人工智能应用》,阐释了语言测评中使用的AI技术及其潜在的风险。基于这些指导性文献和以人为本的AI伦理观,结合语言测试领域的AI伦理风险分析,我们对智能技术赋能的语言测试实践提出了一些操作性建议,以更好地将智能技术应用到语言测试实践中,确保其符合道德和伦理标准,同时最大程度发挥其在提高测试效率和质量方面的优势。具体建议如下:

(1)在开发和实施高风险语言考试时,应确保有人类专家参与审核、监控和评估。

(2)避免提供有偏差的数据用于机器学习,对系统性偏差进行评估、监控和调整。

(3)提升教师和学生的数字素养和智能测评技术应用能力,并提供相关技术支持。

(4)全面评估智能测评技术,以确保考试数据和信息安全,并避免产生版权问题。

(5)测试专家参与智能测评技术开发,提升测试过程的透明度和分数的可解释性。

(6)密切关注智能测评技术应用对社会和教育产生的影响,并努力降低其负面影响。

4.3人机协同的AI应用

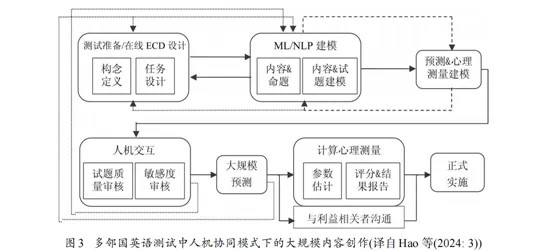

从以上分析我们可以看出,“人机协同”(human-in-the-loop)是规避智能测评技术伦理风险的重要途径。人机协同的主要目的是避免让机器的感知、分析、决策和执行成为一个全自动化的闭环,而是必须在其中嵌入人的因素,使人成为把关者和最终决策者,机器只是人的助手(於兴中等2023)。在人机协同模式下,人类专家和AI系统采取协作策略,共同应对挑战。Hao等(2024)以多邻国英语测试为例,介绍了一个人机合作的AI应用模式(见图3),并描述了人类专家与AI在多邻国测试开发过程中的协同关系。

首先,人类专家通过基于证据的设计流程(evidence-centered design, 简称ECD),界定测试构念并设计测试任务,计算机运用深度学习和自然语言处理等AI技术编写测试内容和试题并完成题库建模,系统进行预测之后完成心理测量建模。审题过程也采用人机交互模式,人类专家审核AI编写的试题质量和测试内容敏感度,通过审核的试题再次由系统进行大规模预测,完成参数估计和AI自动评分,并向考生和用户报告测试结果。经过测试开发过程中的多轮人机协同,测试系统才能正式投入使用。

在命题方面,LLMs和Gen AI的强大功能可以加快测试开发进程,降低测试开发成本,节约人力资源,人类专家则可以更加专注于测试设计、材料和试题审核。在评分方面,研究表明,系统提供的反馈并不能完全满足学习者的需求(Zhang & Hyland 2018;袁莉等2021)。人机协同的模式有助于加强考试分数解释和考试结果反馈,为考生和用户提供更优质的服务。近十年来,自动评分在我国大规模考试中得到了广泛应用。张晓艺等(2024)依托大学英语六级口语考试自动评分系统,对计算机智能评分与人工评分相结合的人机协同模式开展了效度论证。研究发现,人机协同的评分一致性整体上优于传统的人工双评,能够更好地保障考试公平性,并增强考试结果的可解释性。

5.结语

AI技术“具有深度重塑多个测评核心环节的潜能,包括测评开发、心理测量分析方法、测评安全等”(Hao et al. 2024: 3)。但是,人类认知与人工智能的共存是一个复杂而深刻的问题。语言测试领域需要适应时代发展,充分利用智能技术提升考试自动化程度。与此同时,语言测试工作者需要不断评估智能测评技术产生的伦理风险,以确保负责任地应用智能技术。

《新一代人工智能发展规划》(国务院2017)指出,2025年前,我国的人工智能发展将初步建立法律法规、伦理规范和政策体系,形成人工智能安全评估和管控能力;到2030年,将建成更加完善的法律法规、伦理规范和政策体系。这一发展规划体现了我国在应对人工智能发展不确定性时的前瞻性。目前,国际语言测试协会(ILTA)正在修订《ILTA道德准则》和《ILTA实践指南》,以指导语言测试工作者更深入地探索人工智能技术的应用场景,评估可能产生的各方面影响,加强对人工智能技术的研究和监管。唯有如此,语言测试领域才能实现人类认知与人工智能的协同发展,迎接人工智能与人类共存的美好未来。