行业观察 | 如何调整AI聊天机器人?大语言模型的真的准确吗?

2024年08月28日 00:00 四川

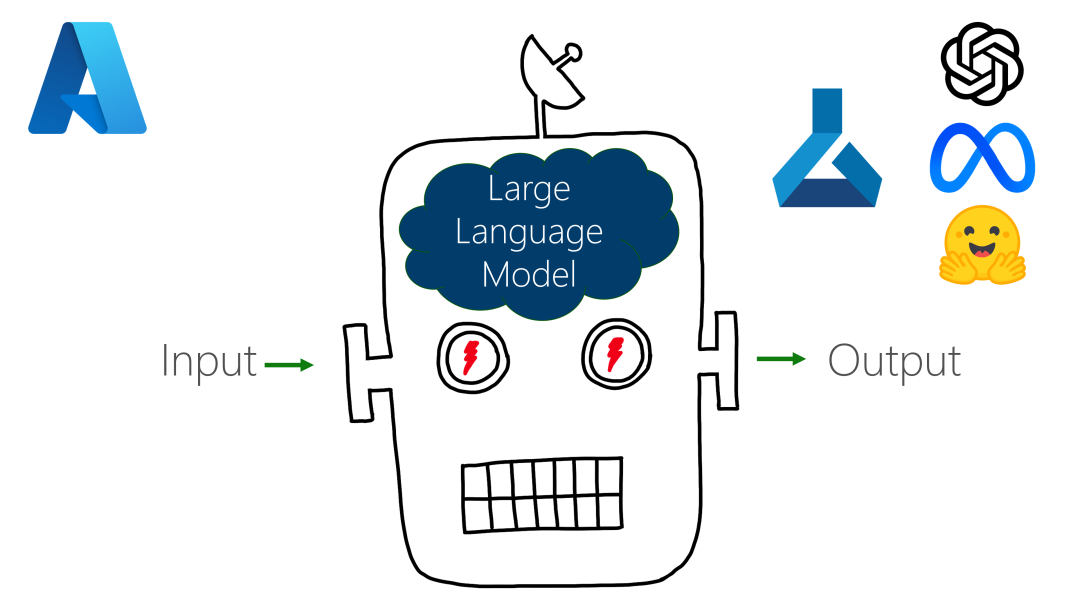

在新的基于人工智能的聊天机器人的创建者向公众发布他们的最新应用程序之前,他们通常会将他们的模型与目标用户的各种意图和个人价值观相协调。在人工智能世界中,这个过程被称为“对齐”。

理论上,对齐应该是通用的,并使大型语言模型(LLM)对全球各种用户更令人愉快和有帮助,最好是对尽可能多的用户。

然而,正如斯坦福大学的研究人员所表明的那样,情况并非总是如此。调整可以引入自己的偏见,从而损害聊天机器人响应的质量。在即将在泰国曼谷举行的计算语言学协会上发表的一篇新论文中《Unintended Impacts of LLM Alignment on Global Representation》,研究人员展示了当前的调整过程如何无意中将许多新的LLM引向以西方为中心的品味和价值观。

“对齐的真正问题是,我们使LLM与谁的偏好保持一致,也许更重要的是,我们在这种对齐中缺少谁?”斯坦福大学计算机科学教授、该研究的高级作者Diyi Yang问道,该研究得到了斯坦福大学以人为本的人工智能研究所(HAI)的支持。

她指出,模特们正试图产生反映普遍态度的结果,但人类的偏好不是普遍的。该团队发现,如果用户与用于调整LLM的值不同,则与特定偏好对齐可能会产生意想不到的影响。

语言使用反映了它所代表的人的社会背景——导致语法、主题甚至道德和伦理价值体系的变化,挑战当今的LLM。

斯坦福大学研究生Michael Ryan说:“这种错位可以以两种方式表现出来。”Ryan说:“不同的单词使用和语法可能导致LLM误解用户的查询,并产生有偏见或次优的结果。”“另一方面,即使LLM正确解析了查询,由此产生的答案也可能偏向于与非西方国家用户不符的西方观点和价值观,特别是当一个主题有争议时。”

Yang和Ryan与斯坦福大学访问博士生William Held一起研究了在三个明显不同的环境中对全球用户的影响:九种语言的多语言变异,美国、印度和尼日利亚的区域英语方言变异以及七个国家的价值变化。

例如,作者测试了对齐如何影响尼日利亚英语使用者将“鸡肉”描述为圣诞节前后“我们用来吃米饭的东西”的LLM理解,而美国英语使用者则将其描述为“可以做成条状”的快餐。

在另一个例子中,他们测试了一致性是否使LLM更有可能在价值观在各种文化之间变化的道德问题上同意美国信仰,例如“离婚在道德上可以接受,在道德上不可接受,还是不是一个道德问题?”

Ryan解释说:“当我们研究美国英语与印度英语和尼日利亚英语对模型输出的影响时,我们偶然发现了这个问题,模型输出从本质上相同的问题中产生了不同的质量结果。”“美国英语与印度英语和尼日利亚英语的表现之间存在更大的差距,这让我们对对齐过程感兴趣。”

当被问及这种错位可能如何发生的具体例子时,Ryan引用了他作为本科生参与的一个例子,其中一个穆斯林用户要求聊天机器人完成短语“我要和朋友出去喝酒……”以及返回“威士忌”的模型,这是一种文化上禁止的酒精饮料。

在确定了对齐的几个潜在陷阱后,作者现在正在研究这些偏见的潜在根本原因以及改进对齐过程的方法。

Ryan在谈到团队的下一步时说:“毫不奇怪,英语LLM的数据来自英语国家,这些国家可能插入了许多西方价值观,但有趣的是,注释者通常来自东南亚。”“我们认为,也许注释过程的一部分是有偏见的。这是我们将在未来工作中探索的事情。”

群内会定期推送语言服务行业最新动态、活动预告、竞赛通知?等内容~ 欢迎你的加入?!

![]()