技术科普 | Evaluation is All You Need!首个开源多模态大模型通用评测器LLaVA-Critic

2024年10月16日 00:15 陕西

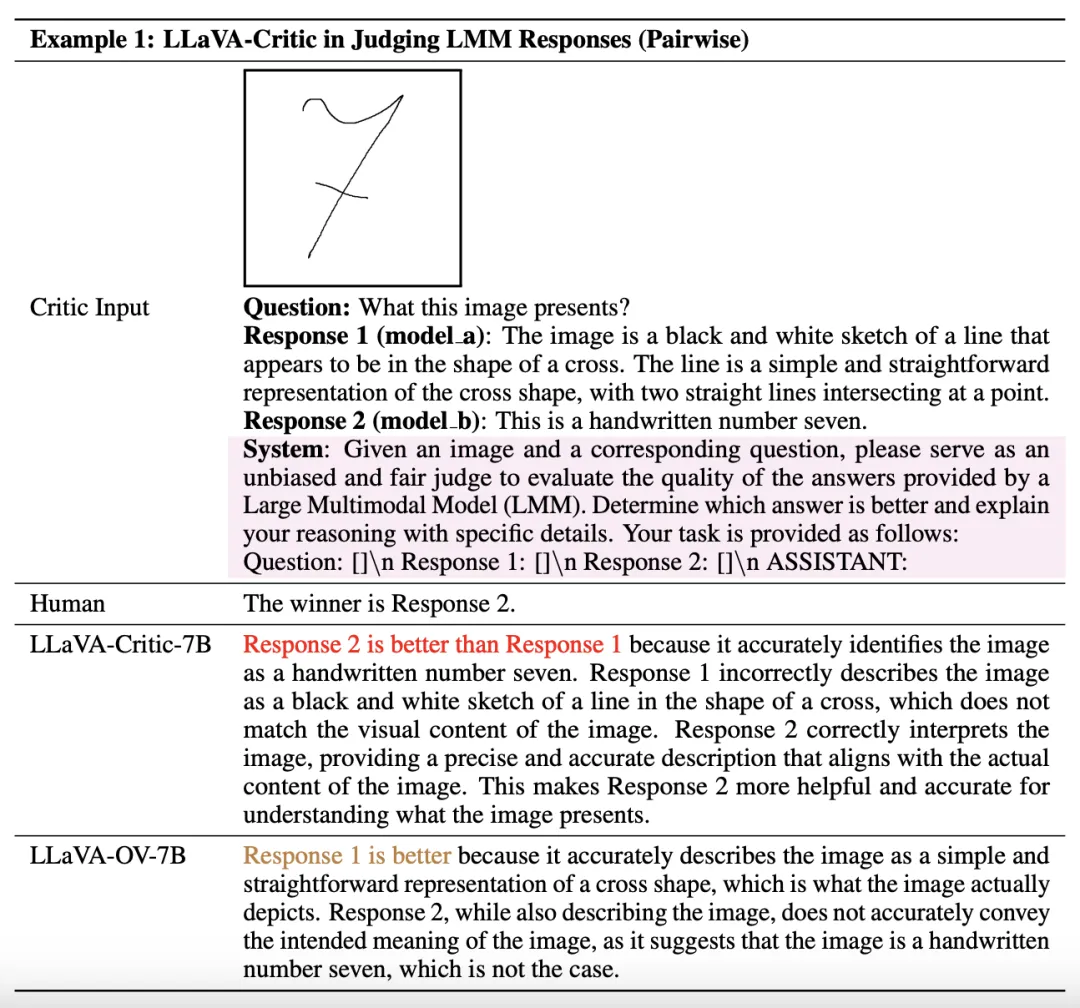

例如,一个AI评测器可以遵循用户设计的评分标准,在视觉对话任务中为不同模型的回复(model response)提供1到10的评分。除了评分外,它还会提供相应的给分理由,确保模型性能评测的透明性和一致性。

-

论文标题:LLaVA-Critic: Learning to Evaluate Multimodal Models

-

论文链接:https://arxiv.org/abs/2410.02712

-

项目主页:https://llava-vl.github.io/blog/2024-10-03-llava-critic/

-

数据与模型开源:https://huggingface.co/collections/lmms-lab/llava-critic-66fe3ef8c6e586d8435b4af8

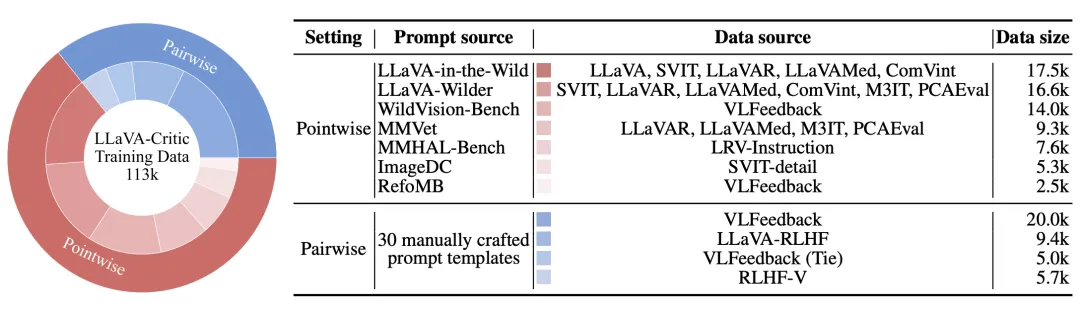

2. 成对排序(pairwise-ranking):对于两个(一对)模型回复,给出二者之间的偏序关系或宣布平局。

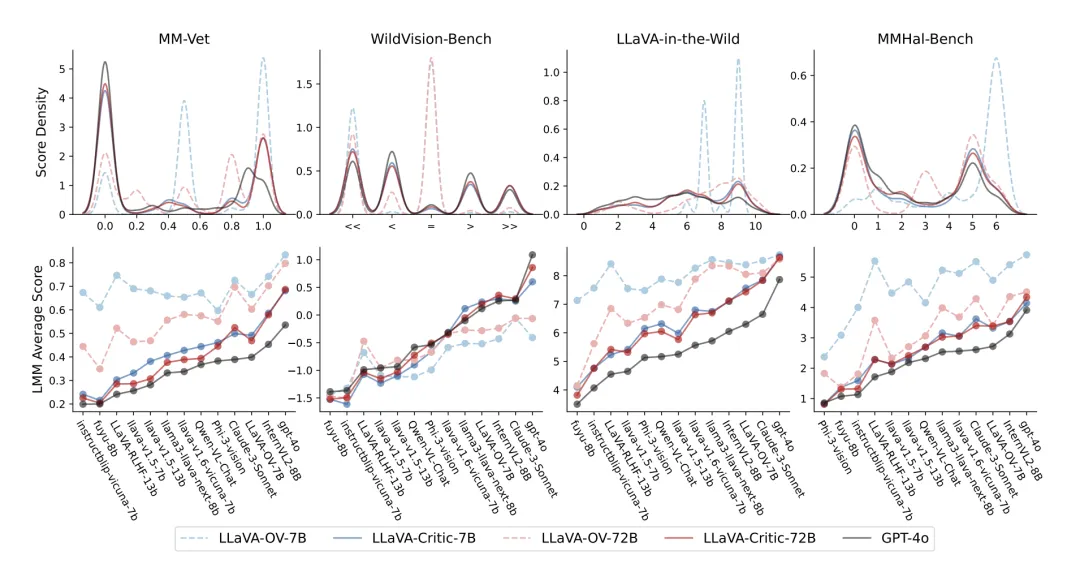

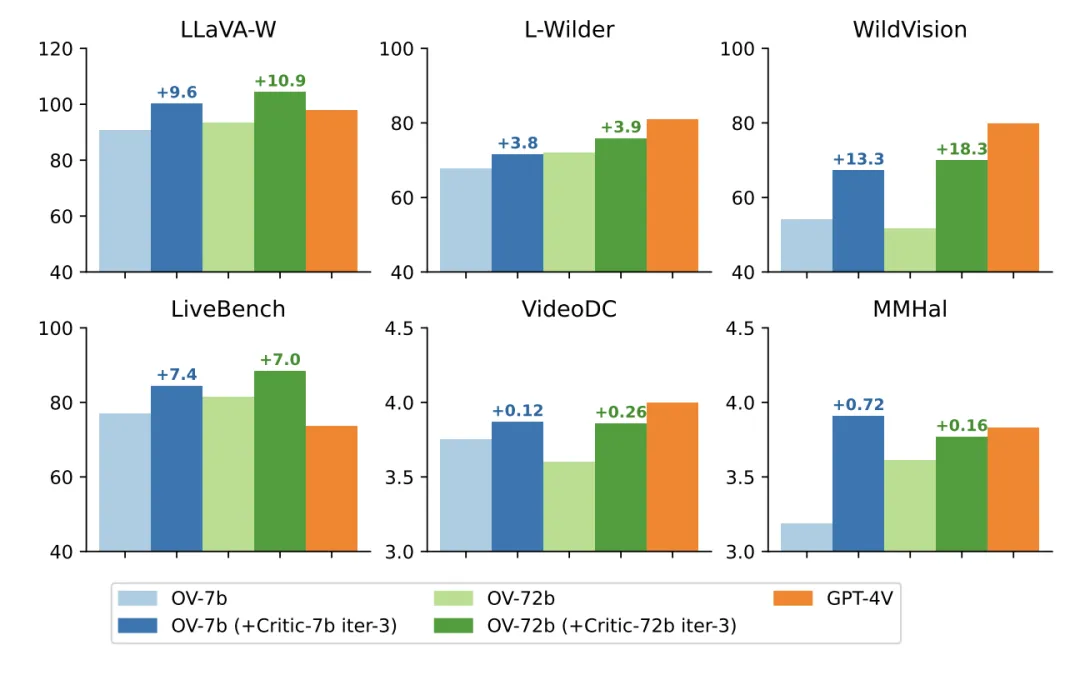

在评分的整体分布和对回复模型 (response model) 的排序层面上,LLaVA-Critic均展现了与GPT-4o的一致性。

给定一个预训练LMM和一组图片-问题输入,首先让LMM对每一个图片-问题输入随机生成K=5个候选回复,由此构建出Kx (K-1)=20个成对回复。 接着,使用LLaVA-Critic对这20个回复对进行成对排序,选出最好和最坏的回复,形成成对的反馈数据集。 之后,使用这一数据集对于预训练LMM进行直接偏好优化(DPO)训练。 在此基础上,渐进式迭代这一过程共计M轮,每次使用最新训练的模型生成候选回复,最终得到与LLaVA-Critic反馈对齐的模型。

特别说明:本文仅用于学术交流,如有侵权请后台联系小编删除。