AIGC时代,人工智能究竟蕴藏着怎样的强大力量?从语料清洗、编程辅助,到数据分析……AI辅助的语料库建设与应用正成为当前学界关注的热点话题。随着AIGC时代来临,我们如何使用人工智能技术,走上学术研究前沿?

8月26日,由上海海事大学刘世界博士主讲的”AIGC时代的语料库建设与应用:基础与进阶“专题课完美画上句号。本次专题课紧紧围绕讲师的阐述、生动案例的引导,以及实际操作的亲身体验,全方位地传授着AI辅助下的语料库构建方法、技巧与理念。

接下来,就跟随小编回顾本次专题课的精彩内容吧~

本次专题课的主要内容包括:

1、语料库核心概念与基础知识

2、语料库建设流程与实操演示

3、案例驱动的语料库分析工具应用(一)

4、案例驱动的语料库分析工具应用(二)

5、基于编程的语料数据应用探索与实践(一)

6、基于编程的语料数据应用探索与实践(二)

第一讲中,世界博士详细阐述了语料库的核心概念、分类以及语料库相关术语辨析。同时,他以208篇涵盖北大核心与CSSCI论文为例,为我们梳理了语料库研究的不同方向及历时研究趋势。此外,他还基于全国哲学社会科学办公室的立项统计数据梳理理念来语料库研究相关的热点及方法论,同时梳理了国内语料库研究领域中的部分代表性学者。这些内容的分享及解读不仅帮助我们建立了对语料库基本概念的清晰认识,也为未来的学习和研究提供了有益的指引。

(语料库立项统计)

(数据来源:哲学社会科学办公室官网)

语料库建设流程与实操演示

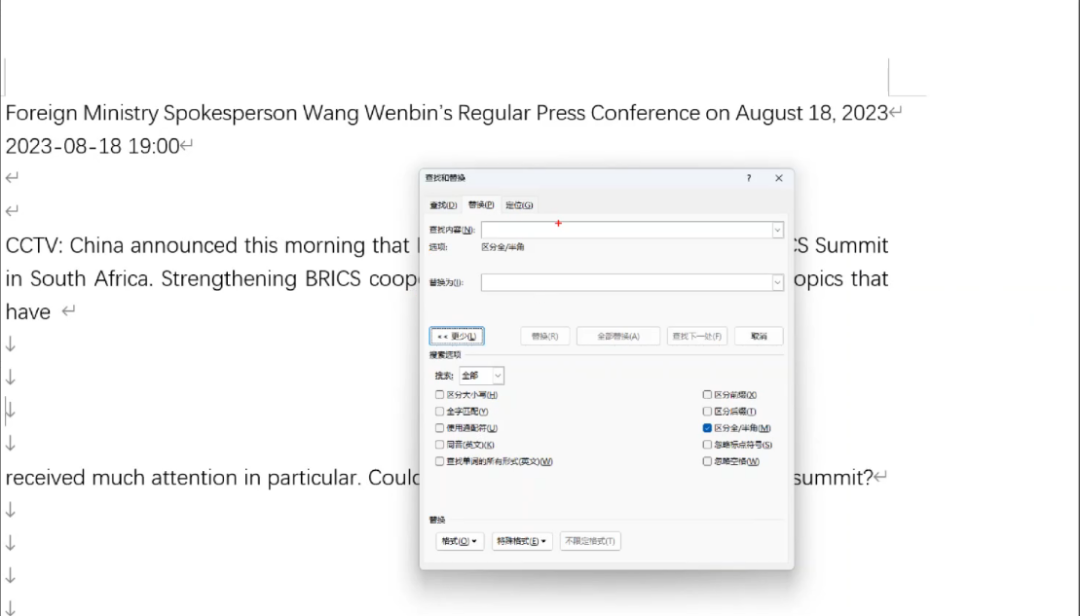

第二讲中,世界博士通过实际操作,为学员演示了语料采集、加工、检索应用等语料数据处理与应用全流程。首先语料采集部分分为自动化采集和人工采集,世界博士为大家分享了许多亲测好用自动化语料采集器,例如:八爪鱼采集器、火车头采集器、后裔采集器,TextForever等。人工采集语料也可以通过一些工具来协助我们做到批量文本处理与转换,例如文本处理可以使用ABBY FineReader、天若文字识别等OCR软件;格式转换可以使用Convertio、iLovePDF等做到不同格式间无痛切换。接下来,世界博士从语料清洗、语料对齐、格式转换、分词赋码四个方面介绍了语料加工流程,并基于基本的检索工具演示语料辅助翻译实践及词典编纂的应用。

(使用正则表达式清洗语料)

案例驱动的语料库分析工具应用

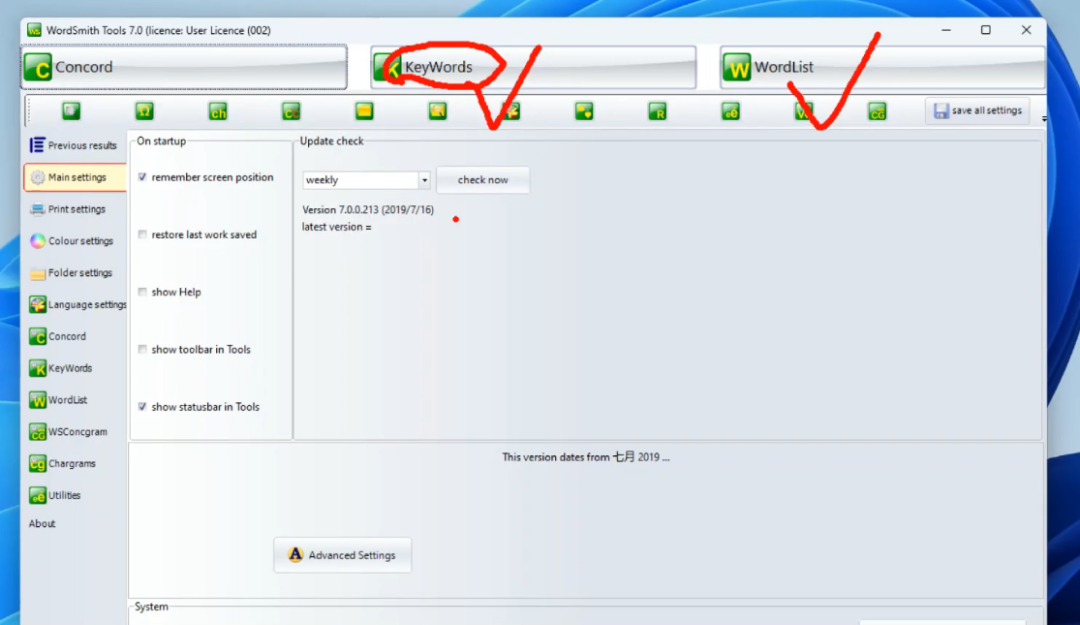

在第三、四讲中,世界博士采用讲师讲解、案例驱动、实践操作相结合的方式,全面介绍语料库的核心概念、基础知识与研究方法,探讨语料库完整的建设流程,以案例驱动的方式引导学员学习语料库分析工具的应用。以事先预备的语料为演示内容,带大家上手操作WordSmith Tools 7.0、Sketch Engine、Wmatrix、Cho-Metrix、BNCweb、COCA等语料分析工具及平台。他强调了在语料库建设中需要关注的关键数据,例如频率、词汇共现、语义域、主题词、 搭配、N-Grams、Keyness、Effect等,同时详细解读了语料库语言学中统计分析相关的数据、衡量指标及概念(如Chi-Squared、Log-Likelihood、TextDispersionKeyness、Dice、MI、MI2、MI3、MS、Mu、RRF、T-Score、Z-Score、p值、T检验、错误拒绝零假设等)意义,针对每个工具和平台的具体统计数据进行详细解释,并总结如何在研究中进行正确汇报。最后,世界博士横向对比了这些语料分析工具/平台的优势与所擅长分析的领域。

(以实际案例演示WordSmith Tools 7.0的详细操作)

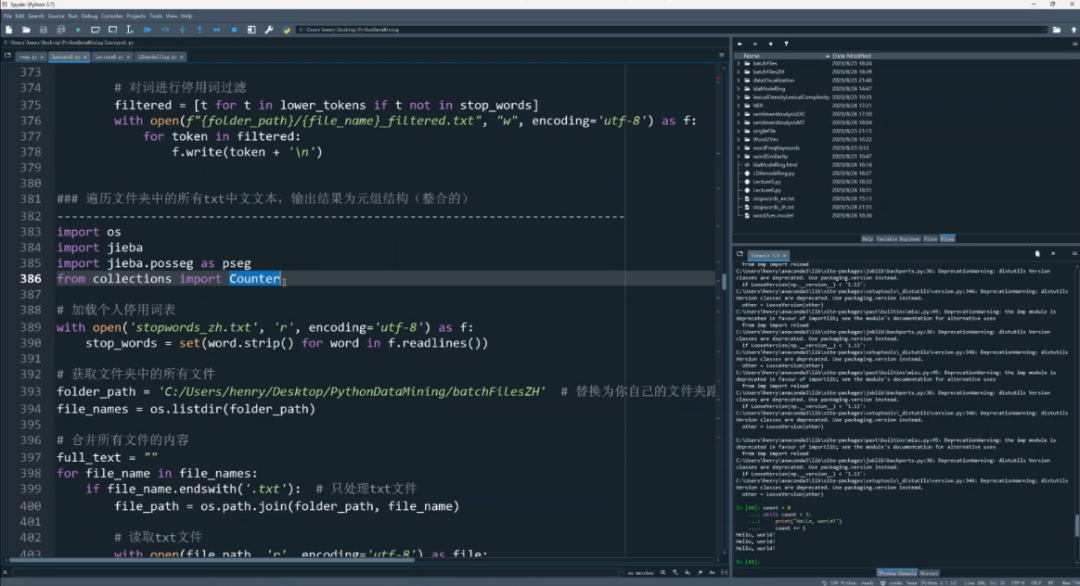

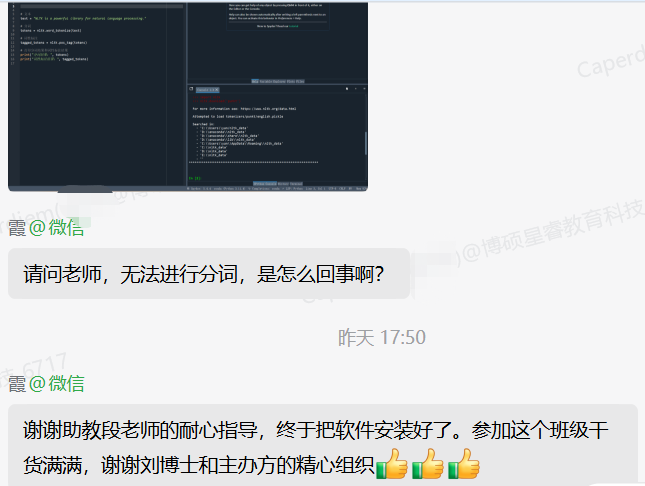

在第五、六讲中,世界博士从ChatGPT辅助Python编程入门开始,为大家详细讲解了Python应用中的数据类型、数据结构、常用函数及语句,实操演示了如何运用Python实现语料存储与读取、语料数据预处理、词频统计与关键词提取、语料数据视图化方法、词向量训练、文本分类与情感分析、命名实体识别、LDA(Latent Dirichlet Allocation)主题建模等典型应用场景,在关键部分世界博士详细解释了每一行代码的构造、内容及执行的目的。世界博士将课程从开发环境配置开始,一直引导大家动手实操进行语料分析与应用整个流程,旨在帮助学员在实践中掌握如何利用编程技术进行语料数据的复杂处理和多元分析。

(基于Python的语料数据处理与应用)

除了课程内容外,世界博士还在群内耐心解答了各种问题。课程内容丰富实用,受到学员们的高度评价。

(部分学员好评截图)

“AIGC时代的语料库建设与应用专题课程:基础与进阶”暂告一段落啦~

接下去我们还有翻译技术及语料库应用研修班等待大家哦~

特别说明:本文仅用于学术交流,如有侵权请后台联系小编删除。

– END –

转载来源:语言服务行业

转载编辑:邢薇